عملکرد نژادپرستانه واتساپ جنجالی شد

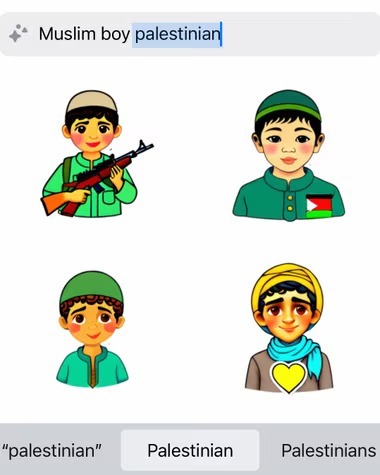

به گزارش گروه علمی و فناوری خبرگزاری برنا؛ یکی از ویژگیهای واتساپ که در پاسخ به جستجوی کاربران تصاویر مختلفی تولید میکند، زمانی که عباراتی مثل «فلسطینی»، «فلسطین» یا «پسربچه مسلمان فلسطینی» مورد جست و جو قرار میگیرد، تصویری از یک اسلحه یا پسری با تفنگ را نشان میدهد.

در مقابل و برای مثال، وقتی برای کلماتی مثل «پسر اسرائیلی» جست و جو انجام میشود، کارتونهایی از کودکانی که فوتبال بازی میکنند و کتاب میخوانند، ارائه میشود.

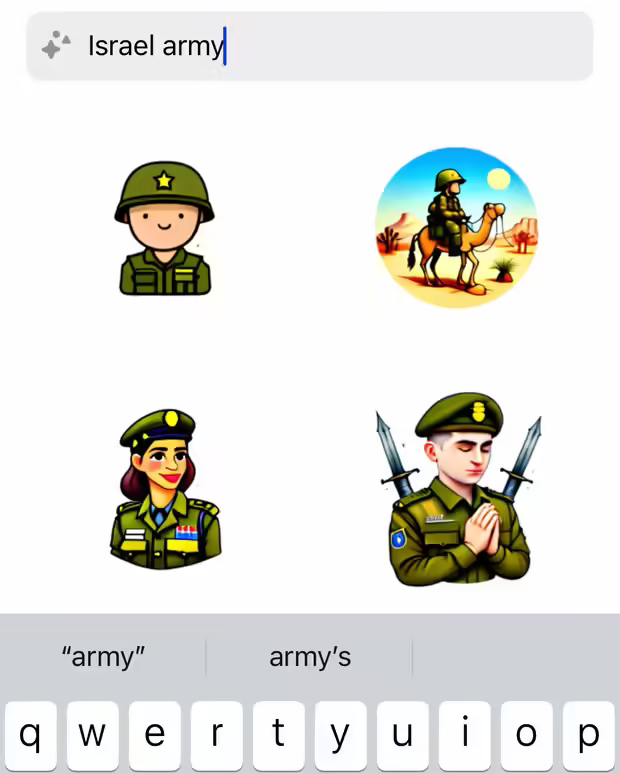

همچنین در پاسخ به درخواست کلمه «ارتش اسرائیل»، هوش مصنوعی نقاشیهایی از سربازان خندان و در حال دعا کردن ایجاد کرد که البته بدون اسلحه بودند.

واتساپ متعلق به متا است و در ویژگی جدید خود به کاربران این امکان را می دهد که تولیدکننده تصاویر مبتنی بر هوش مصنوعی باشند. این ویژگی از کاربران میخواهد «ایدهها را با هوش مصنوعی به برچسب (استیکر) تبدیل کنند».

در مجموع ۲/۸ میلیارد نفر در جهان، کاربر چهار برنامه پرطرفدار متعلق به شرکت متا یعنی اینستاگرام، واتساپ، فیسبوک و فیسبوک مسنجر هستند.

نکته قابل توجه اینجاست که ویژگی جدید واتساپ وقتی کلماتی در خصوص «اسرائیل» یا حتی عبارت صریح «ارتش اسرائیل» را جست و جو میکند، محتوای نهایی بدون هیچ خشونتی منتشر و به تصاویری با اسلحه منجر نمیشود و تصاویر کارتونی افرادی را با ژستهای مختلف در حالی که یونیفرم پوشیده و عمدتاً خندان و شاد هستند، به تصویر میکشد.

این عملکرد متا که یک طرفه بوده و مصداق ترویج اسلامهراسی و نژادپرستی در شبکههای اجتماعی محسوب میشود، از سوی کاربران زیادی مورد انتقاد قرار گرفته و البته در پاسخ، متا گفته که «هیچوقت قصد ما سرکوب یک جامعه یا دیدگاه خاص نبوده و نیست».

کوین مکآلیستر، سخنگوی متا، گفته که این شرکت از این مشکل آگاه بوده و به آن پرداخته است و ادامه داد: «همانطور که گفتیم هنگام فعال سازی این ویژگی، مدلها میتوانند خروجیهای نادرست یا نامناسب را مانند تمام سیستمهای هوش مصنوعی تولیدی ارائه دهند. ما همچنان به بهبود این ویژگیها ادامه میدهیم».

به گفته منتقدان عملکرد این ویژگی جدید واتساپ، تصاویر هوش مصنوعی از کودکان فلسطینی که با اسلحه در واتساپ به تصویر کشیده میشوند، مصداق بارزی از معیارهای نژادپرستانه و اسلام هراسی است که در این الگوریتم گنجانده شده است.

انتهای پیام/