دیپ فیک چیست؛ وقتی مرزی بین حقیقت و دروغ باقی نمیماند

به گزارش گروه اجتماعی برنا؛ ماه نوامبرِ سال ۲۰۲۰ میلادی است و درست چند روز تا آغاز رأیگیری انتخابات ریاستجمهوری ایالات متحده آمریکا فاصله داریم. مردم، خود را برای شرکت در انتخابات آماده میکنند که بهناگهان ویدئویی عجیب و بهتآور در سراسر اینترنت منتشر میشود. همه درنهایت بهت و حیرت، نامزد پرسروصدا و احتمالاً محبوبشان را مشاهده میکنند که از تشخیص سرطان بدخیم توسط پزشکانش خبر میدهد؛ «من برای رهبری بیشازاندازه ناتوان و بیمار هستم؛ لطفاً به من رأی ندهید.»

هیچکس نمیداند که چه بلایی بر سرِ آینده کشور خواهد آمد. درحالیکه گمانهزنیها درباره بیماری آقای رئیسجمهورِ احتمالی شروع شده، خبری دیگر در رسانههای اجتماعی مثل بمب صدا میکند که بهمراتب از خبر پیشین شوکهکنندهتر است.

اینطور که بهنظر میرسد، یک ملت بازیچهی دستِ یکسری افرادِ ناشناس شدهاند؛ بله درست حدس زدهاید، هیچ سرطانی در کار نبوده و تمامِ اتفاقاتِ ویدئو موردبحث، بهصورت مصنوعی و توسط هوش مصنوعی درست شده است. عدهای همچنان در شوک قرار دارند و نمیتوانند اتفاقاتِ روزهای گذشته را هضم کنند؛ درحالیکه گروهی دیگر از مردم، چنین خبری را تغییر نظر سریع آقا یا خانم نامزد بهحساب میآورند.

برداشتها هرچه که باشد، دیگر کار از کار گذشته و سرنوشت یک کشور، یا بهتر است بگوییم سرنوشت یک جهان در مسیرِ دیگری قرار گرفته است.

سناریوی بالا اگرچه درظاهر تخیلی بهنظر میرسد، اما باوجود پدیدهای جدید بهنام دیپفیک، میتوان بهوقوعپوستنِ این تخیل را در دنیای واقعی متصور شد.

در دهه ۱۹۷۰ تا ۱۹۸۰ میلادی، شرکتی با نام Memorex در حوزهی تولید نوارهای کاست فعالیت میکرد. در تمام کمپینهای تبلیغاتی این شرکت، همواره یک جملهی خاص تکرار میشد: «آیا این صدای واقعی است یا Memorex چنین کیفیتی دارد؟»

با گذشت حدود ۴۰ سال از آن زمان، اکنون باری دیگر در موقعیتی مشابه قرار گرفتهایم؛ بااینتفاوت که اکنون موضوع بحث دیگر بهاندازهی کیفیت نوارکاست و زندهبودن صدای منتشرشده از آن، پیشپاافتاده نیست؛ بلکه حالا باید مرز حقیقت و دروغ را از یکدیگر تشخیص دهیم.

طی روزها یا حتی ماههای گذشته، ممکن است بارها به ویدئوهای دیپفیک برخورده باشید؛ ویدئوهایی که اساساً هیچگونه انطباقی با حقیقت ندارند اما بهسبب واقعگرایانهبودنشان، نمیتوان متوجه جعلیبودن آنها شد. از سیاستمداران معروف تا هنرمندان مشهور و حتی مدیران مطرح دنیای فناوری، همگی در ماههای گذشته بهنوعی با این پدیده نوظهور دستوپنجه نرم کردهاند. از عکسهای غیراخلاقی و ساختگی هنرمندان مشهور بگیرید تا سخنرانیهای جعلی سیاستمداران و اظهارنظرهای طنزگونه مدیران فناوری درباره موضوعاتی نظیر حفظ حریم خصوصی، همگی نمونههایی کوچک از عملکرد تخریبگرایانه دیپفیک و اثر منفی آنها روی جامعه هستند.

اینطور که بهنظر میرسد، افق پیشروی دنیای فناوری بیش از آنچه فکرش را میکردیم، شبیه به وقایع سریال بلک میرر (Black Mirror) شده است؛ سریالی که روی تاریک پیشرفتهای فناوری را نشان میدهد.

فعلا نمیدانیم که آینده چهچیزی پیشرویمان میگذارد؛ اما اگر پدیده دیپفیک با سرعت فعلی، بدون محدودیت به پیشروی خود ادامه دهد، در آیندهای نزدیک با دنیایی تاریکتر از تصورات بدبینترین افراد مواجه خواهیم شد.

در هفتهی گذشته، برای نخستینبار قانونگذاران کنگره راجعبه این پدیدهی نوظهور و خطراتش به بحث و گفتوگو پرداختند.

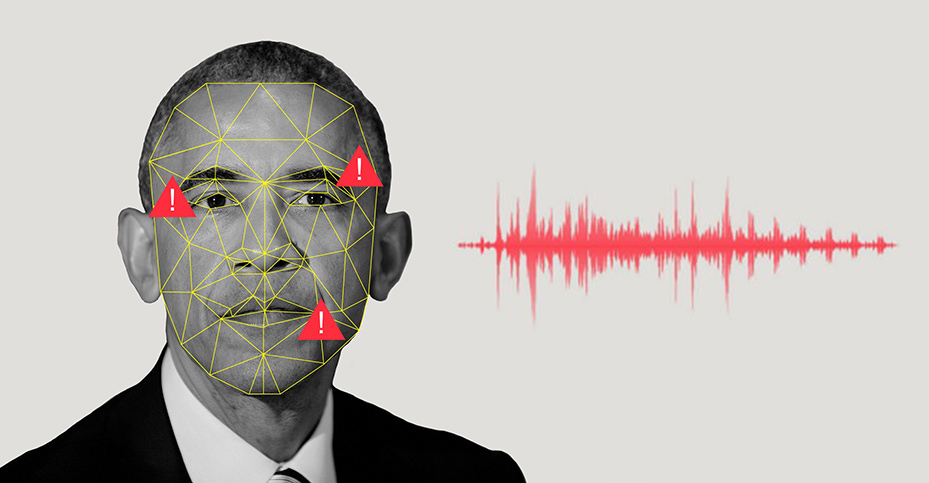

باراک حسین اوباما، رئیسجمهور پیشین آمریکا در گفتوگویی که بهتازگی انجام داده، نگرانی خود را درباره پیشرفت دیپفیک ابراز کرده است:

افراد قادر به تکثیر من و تغییر سخنهایم هستند و این کار بهاندازهای دقیق انجام میشود که گویی نسخه تکثیرشده، بهواقع من هستم و آن صحبتها از زبان من گفته میشود؛ درحالیکه همهچیز کاملاً ساختگی است. اگر به مرحلهای برسیم که نتوان مرز بین حقیقت و دروغ را تشخیص داد، پایههای دموکراسی ما که برمبنای حقیقت بنا شده، به لرزه خواهد افتاد.

صحبتهای اخیر رئیسجمهور پیشین آمریکا بهدنبال پخش همهگیر ویدئویی دروغین از وی انجام شده که در ویدئو موردبحث، باراک اوباما جانشین خود، یعنی دونالد ترامپ را فردی کاملاً غیرمنطقی و حقیر خطاب میکند.

دیپفیک چیست؟

دیپفیک نام یک تکنیک نرمافزاری مبتنیبر هوشمصنوعی است که در محتوای صوتی و تصویری دست میبرد و آن را بهدلخواه دگرگون میسازد؛ بنابراین نتیجهی نهایی که بهدست میآید، چیزی کاملا متفاوت از حقیقت خواهد بود. درواقع نام این تکنیک نیز بهدرستی عملکرد آن را آشکار میسازد؛ دیپفیک، ترکیبی از یادگیری عمیق (Deep Learning) و جعل (Fake) است.

شاید عجیب باشد؛ اما کارگردانان سینما یکی از قدیمیترین استفادهکنندگان از این فناوری بودهاند. سِر پیتر کوشینگ، بازیگر انگلیسی که نقش «گرند ماف تارکین» را تا پیشاز مرگش در سال ۱۹۹۴ در مجموعه فیلمهای جنگ ستارگان بازی میکرد، باری دیگر در فیلم «روگ وان: داستانی از جنگ ستارگان» که مربوطبه سال ۲۰۱۶ میشود، ظاهر شد. در همین فیلم با استفاده از تکنیک مشابه، شخصیت «پرنسس لیا» هم بازسازی و جوان شد. در نمونهای دیگر، ستارهی فیلم «سریع و خشن»، یعنی پاول واکر را داریم که پیشاز تکمیل فیلمبرداری هفتمین قسمت از این سری در یک تصادف رانندگی درگذشت؛ اما بهلطف دیپفیک، هنوز شاهد هنرنمایی این بازیگر سری فیلمهای سریع و خشن هستیم.

درواقع این فناوری نیز برای ایجاد محتوای صوتی و تصویری متقاعدکننده و درعینحال غیرواقعی ساخته شده؛ یک فناوری که بهسرعت در حال رشد و بهبود است و انتظار میرود روزبهروز استفاده از آن گستردهتر شود. برنامههای ویرایش تصویر نظیر فتوشاپ، سالها کاری مشابه را ازطریق جعلکردن تصاویر انجام میدهند؛ اما چیزی که اکنون با آن روبهرو هستیم، مبحثی کاملاً متفاوت و نگرانکنندهتر از جعل عکس یک نفر در فتوشاپ است.

با پیشرفت خیرهکننده هوشمصنوعی طی سالهای اخیر، بسیاری از کارهایی که در گذشته سخت و ناممکن به نظر میرسیدند، ممکن شدهاند. پیشتر، کمتر کسی فکر میکرد که روزی بتوان محتوای یک ویدئو را بهطور کلی و بدون دخالت مستقیم انسان تغییر داد؛ اما اکنون دیپفیک ثابت کرده که چنین باوری در دنیای امروز جایی ندارد و بهراحتی میتوان ویدئوهایی تولید کرد که بهسبب واقعگرایانهبودن، بتوان میان حقیقت و دروغ آنها تمایزی قائل شد.

همانطور که بالاتر اشاره کردیم، دیپفیک یک تکنیک مبتنیبر هوشمصنوعی است؛ بنابراین نیازی به دخالت مستقیم انسان ندارد؛ ازاینرو، هرکسی ازطریق دیپفیک میتواند ویدئویی جعلی و درعینحال واقعگرایانه درست کند.

یکی از محبوبترین اهداف دیپفیک درطول دو سال گذشته، دونالد ترامپ، رئیس جمهور ایالات متحده آمریکا بوده است؛ کسی که دادههای صوتی و تصویری بسیاری از او در اینترنت وجود دارد. حال هر کس که به فناوری دیپفیک دسترسی داشته باشد، بهراحتی قادر به ساخت ویدئویی خواهد بود که دونالد ترامپ را در حال انجام کاری یا صحبتکردن دربارهی کاری غیرمعمول نشان میدهد.

دیپفیک چگونه ساخته میشود؟

چندین راه برای ساخت ویدئوهای دیپفیک وجود دارد؛ اما در تمام این راهها، شما باید مقدار زیادی از داده را به مدلهای یادگیری ماشین تغذیه کرد تا از این طریق محتوای جعلی تولید شود. واقعگرایانهترین نمونههای ساختهشده، حجم عظیمی از دادههای صوتی، تصویری و ویدئویی را طلب میکنند.

شاید برایتان عجیب باشد اما دیپفیک تنها در حوزههای بالا استفاده نمیشود و اپلکیشنی مانند اسنپچت نیز برای اعمال فیلترهای مبتنیبر چهره از چنین فناوری بهره میبرد. جلوتر که برویم، حتی اپلیکیشنهای قویتری در این زمینه وجود دارند؛ اپلیکیشنی مانند FakeApp که توسط توسعهدهندهای ناشناس ساخته شده و با استفاده از نرمافزارهای متنباز گوگل، به کاربران اجازه میدهد تا چهرهی خود را بهصورت واقعگرایانهای با دیگران جابهجا کنند؛ آن هم بدون اینکه دستکاریشدن ویدئو مشخص باشد.

احتمالاً فکر میکنید که چنین کاری نیازمند تبحر و مهارت بسیاری در علومهای کامپیوتری است؛ اما حتی افرادی که در حد انجام کارهای روزمره با کامپیوتر آشنایی دارند، میتوانند بهراحتی شیوهی کارکرد دیپفیک را یاد بگیرند و از آن برای اهداف خود استفاده کنند.

نمونههای ویدئویی از دیپفیک

احتمالاً اولین آشنایی بسیاری از ما با ویدئوهای دیپفیک، همان سخنرانی دروغین باراک اوباما، رئیس جمهور پیشین آمریکا بوده است. بااینحال، اگرچه آن ویدئو یکی از اولین نمونهها بوده؛ اما قطعاً آخرین مورد نبوده است.

طی هفتههای اخیر، ویدئوهای دیپفیک بهدلیل گسترش ناگهانیشان به پدیدهای ترسناک تبدیل شدهاند. در یک نمونه از این ویدئوها، مارک زاکربرگ، مدیرعامل فیسبوک را مشاهده میکنیم که با صدایی رباتگونه، جملهی «هرکسیکه دادهها را کنترل میکند، آینده را کنترل میکند» را بر زبان میآورد. در ادامه میتوانید دو نمونه از این ویدئوها را تماشا کنید.

در ویدئو نخست، جان اسنو، یکی از شخصیتهای محوری سریال «بازی تاج و تخت» را مشاهده میکنیم که در صحنهای از فیلم، بابت تمام اشتباهاتی که این سریال در طول فصل هشتم انجام داده، از طرفداران عذرخواهی میکند. اون فیلمنامه فصل هشت را حاصل کاری ۶روزه عنوان میکند و درآخر از همه میخواهد تا برای فراموشی این فصل، فیلمنامهی آن را در آتش بسوزانند. اگرچه این ویدئو نسبت به دیگر نمونههای دیپفیک از کیفیت پایینتری برخوردار است؛ اما قطعاً با پیشرفت این فناوری میتوان آیندهای را متصور شد که هرکس طبق علایق خود، دیالوگ موردنظرش را برای صحنههای مختلف فیلم درنظر بگیرد.

ویدئوی بعدی که کیفیت بسیار بالاتری دارد، بیل هیدر (Bill Hader) را در حال گفتوگو نشان میدهد؛ اما نکته مهم درباره این ویدئو، تغییر چهره ناگهانی وی به چهره آرنولد شوارتزینگر است. این اتفاق بهقدری طبیعی اتفاق میافتد که گویی چنین رخدادی در دنیای حقیق رخ میدهد.

ادوارد دلپ، مدیر بخش پردازش تصویر و ویدئو در آزمایشگاه دانشگاه پوردو، سرعت و سهولت ساخت ویدئوهای دیپفیک را برای جوامع امروزی یک هشدار جدی میداند. وی یکی از چندین پژوهشگری است که روی توسعهی الگوریتمی برای تشخیص ویدئوهای دیپفیک و جلوگیری از نشر گستردهی آنها در فضای اینترنت کار میکند؛ پروژهای که توسط دولت آمریکا برای مقابله با نشر اکاذیب راهاندازی شده است.

دیپفیک و سقوط اخلاقیات

متأسفانه دیپفیک تنها به یک یا دو حوزهی خاص خلاصه نمیشود و آثار مخرب این فناوری را میتوان در جنبههای مختلف زندگی مشاهده کرد.

یکی از بحثبرانگیزترین و غیراخلاقیترین زمینههای فعالیت دیپفیک، تولید محتوای ویدئویی بزرگسالانه است. سال ۲۰۱۷ میلادی، کاربری در وبسایت ردیت؛ ویدئویی غیراخلاقی و دروغین از بازیگری با نام Gal Gadot منتشر کرد که وی را درحال ایفای نقش در فیلمهای غیراخلاقی نشان میداد. اگرچه این ویدئو توسط فناوری دیپفیک ساخته شده بود؛ اما نوع مونتاژ بهگونهای بود که در نگاه نخست کمتر کسی میتوانست متوجه جعلیبودن ویدئو شود.

طولی نکشید که اتفاقات مشابه با همین مضمون برای دیگر بازیگران مطرحِ سینما رخ داد؛ بدینگونه، افرادی که در ابتداییترین جنبههای زندگی روزمره خود جانب احتیاط را پیشه میکنند، خود را در ویدئوهایی دیدند که پیشتر تصور آن نیز از ذهنها دور بواسکارلت جوهانسون، یکی از بازیگران مطرح سینمای هالیوود که خود قربانی این ویدئوها بوده است، میگوید:

تلاش برای محافظت از خود دربرابر اینترنت و آثار مخرب آن اساساً یک تصمیم بیهوده است. هیچچیزی نمیتواند جلودار شخصی شود که دست به چنین کاری میزند.

بااینحال، فقط افراد مشهور نیستند که در دام دیپفیک گرفتار میشوند. اساساً هرشخصی که در اینترنت و شبکههای اجتماعی فعالیت داشته باشد و حداقل یک عکس یا ویدئو از خود با دیگران بهاشتراک گذاشته باشد، بهناگهان میتواند خود را درحال انجام کاری ببیند که در تاریکترین لایههای ذهنش نیز ساخته و پرداخته نمیشود.

حتی در این زمینه ابزارهایی نیز ساخته شدهاند تا فرایند ساخت چنین ویدئوهایی سادهتر شود؛ بهعنوان نمونه میتوان به موتور جستجویی اشاره کرد که تصویر اشخاص عادی جامعه را دریافت میکند و براساس آن شبیهترین بازیگر فیلمهای بزرگسالان را پیشنهاد میدهد تا از ویدئوهای وی برای ساخت محتوای غیراخلاقی دروغین با چهره فرد موردنظر استفاده شود.

متأسفانه گسترش این موضوع باعث شده تا عدهای از این راه کسب درآمد کنند. در انجمنهای اینترنتی، عدهای بابت ساخت ویدئوهای غیراخلاقی از فرد موردنظرشان، قیمتهای بالایی پرداخت میکنند. طبق یافتههای واشنگتنپست، تنها در یک مورد، شخصی نزدیک به ۵۰۰ عکس از چهره فرد موردنظرش را در یکی از این انجمنها آپلود کرد؛ فردی که بابت کار باکیفیت، پول خوبی نیز پرداخت میکرد؛ موضوع تأسفبرانگیز این است که هیچ قانونی برای توسل قربانیان به آن، فعلا تدوین نشده است.

فرای نگرانیها درباره حریم خصوصی، متخصصان پیشبینی میکنند که دیپفیک در آینده نزدیک به یکی از بزرگترین خطرها برای دموکراسی و امنیت ملی کشورهای تبدیل شود.

بهعنواننمونه، رقبا و دشمنان آمریکا میتوانند با ساخت تصاویر، ویدئو و فایلهای صوتی جعلی اما واقعگرایانه، در انتخابات پیشرو تأثیر بگذارند.

در مقالهی مفصلی که سال گذشته توسط دو متخصص حوزه حقوقی، یعنی باب چزنی و دنیل سیترون به نگارش در آمد، آنها به جوانب مختلف دیپفیک اشاره کردند. به باور آنها، دیپفیک میتواند سربازان یک ارتش را در حال شلیککردن به شهروندان بیگناه نشان دهد یا افسر پلیس سفیدپوستی را صرفاً برای افزایش تنش نژادی، در حال شلیککردن به یک مرد سیاهپوست غیرمسلح به تصویر بکشد.

در این میان، شبکههای اجتماعی بزرگ نظیر فیسبوک که نقش پررنگی در انتقال اخبار دارند، هیچ عکسالعملی را نسبت به محتوای دیپفیک نشان ندادهاند؛ امری که نگرانیها درباره گسترش چنین پدیدهای را بیش از پیش تشدید میکند.

چنین اتفاقی نه تنها اطلاعات نادرست را در سطح جامعه گسترش میدهد بلکه پذیرش حقیقت را نیز توسط افراد به امری سخت و ناممکن تبدیل میسازد. تصور کنید شبکههای اجتماعی پر از ویدئوهای جعلی و دروغین باشد، رهبران سیاسی کشورها حرفهای پیشین خود را تکذیب کنند و افراد جامعه همواره نگرانی سوءاستفاده از تصاویرشان را با خود بههمراه داشته باشند. در این صورت با جامعهای بیمار و بدگمان روبهرو خواهیم شد که به همهچیز مشکوک است، سخنان رهبرانش را باور ندارد و از آن سو رهبران سیاسی کشورها نیز بهسادگی و با پناهبردن به واژه دیپفیک، نهتنها هیچ انتقادی را نمیپذیرند بلکه حرفهای واقعی خود را نیز تکذیب میکنند تا از زیرِ بار مسئولیت شانه خالی کنند. در چنین جامعه یا بهتر است بگوییم چنین جهانی، دیگر مرزی بین حقیقت و دروغ باقی نمیماند، «اعتماد» به واژهای بس مضحک تبدیل میشود و دروغ، خوراک روزانه همگان خواهد شد.

در چنین جهانی با هر دروغی که میگوییم، دیگر دِینی به حقیقت نخواهیم داشت؛ زیرا دیگر حقیقتی باقی نمیماند که بخواهد روزی از میان خرابههای تمدنِ (بهظاهر) انسانی سر به بیرون بیاورد.

اکنون باید این سؤال را پرسید که آیا پیشرفت لجامگسیخته و بیمهابای فناوری در تمامی زمینهها، ارزش این را خواهد داشت تا پایههای جامعهی خود را نابود سازیم و آینده را بر ویرانههای تمدن بشری نظارهگر باشیم؟